AWS API Gateway는 RESTful API를 간편하게 구축할 수 있는 서비스이며, AWS Lambda는 서버리스 기술을 사용하여 코드를 실행하는 서비스입니다. 두 서비스를 통합하여 파일 업로드 기능을 구현할 수 있습니다.

- AWS Lambda 함수 생성하기

- AWS Management Console에서 AWS Lambda로 이동합니다.

- "Create function"을 클릭합니다.

- "Author from scratch"를 선택하고, 함수 이름, 런타임, 권한을 설정합니다.

- "Create function"을 클릭하여 함수를 생성합니다.

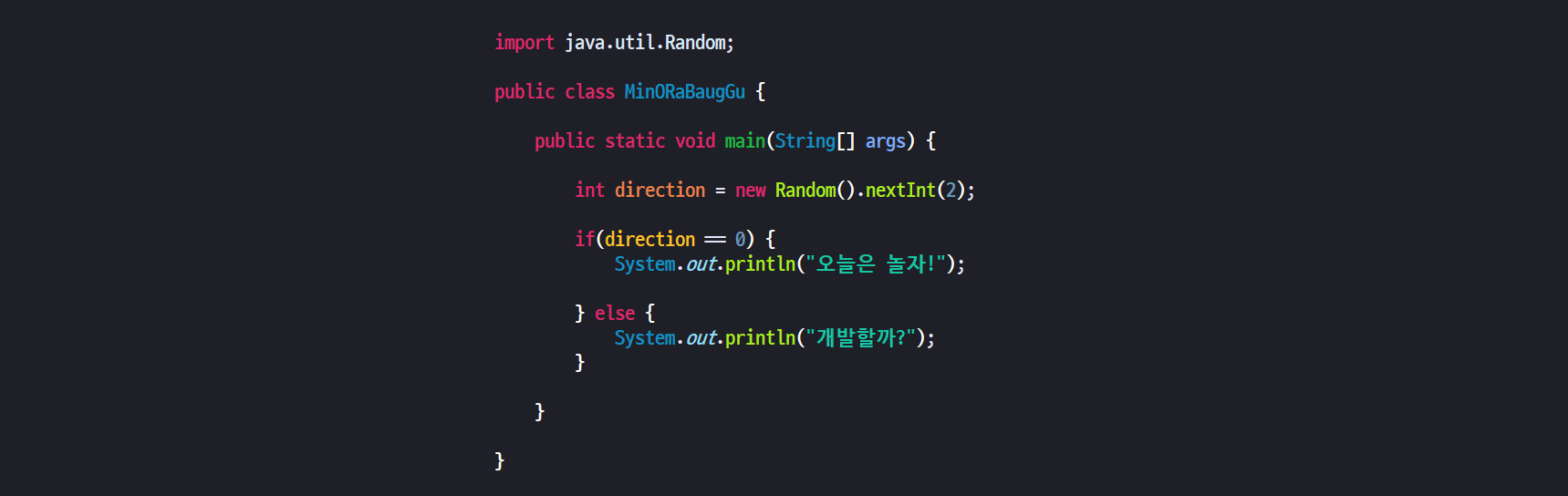

- AWS Lambda 함수 코드 작성하기

AWS Lambda 함수에서는 파일 업로드를 처리하는 코드를 작성할 수 있습니다. 아래의 샘플 코드는 파일 업로드를 처리하는 Node.js 코드입니다.

const AWS = require('aws-sdk');

const s3 = new AWS.S3();

exports.handler = async (event, context) => {

const { file } = JSON.parse(event.body);

const buffer = Buffer.from(file.replace(/^data:image\/\w+;base64,/, ""), 'base64');

const params = {

Bucket: 'my-bucket',

Key: 'my-file',

Body: buffer,

ContentEncoding: 'base64',

ContentType: 'image/jpeg'

};

await s3.putObject(params).promise();'개발 > Cloud' 카테고리의 다른 글

| AWS lambda payload 6mb limit - chatGPT 작성 (0) | 2023.02.07 |

|---|---|

| AWS Lambda Cold Start & Warm Start - chatGPT 작성 (0) | 2023.02.06 |